| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |

- 42서울

- 캡스톤디자인프로젝트

- bastion host

- Spring boot

- 스프링부트

- 게임개발동아리

- EC2

- 프롬프트엔지니어링

- spring ai

- Redis

- 라피신

- 도커

- 개발공부

- 프리티어

- 생활코딩

- 오블완

- openAI API

- 체크인미팅

- Route53

- UNICON

- UNICON2023

- 백엔드개발자

- NAT gateway

- CICD

- UNIDEV

- 인프라

- 전국대학생게임개발동아리연합회

- 티스토리챌린지

- AWS

- 프로그래밍

- Today

- Total

Hyun's Wonderwall

[AIchemist] 07. 문서 군집화 소개와 실습(Opinion Review 데이터 세트) 본문

[AIchemist] 07. 문서 군집화 소개와 실습(Opinion Review 데이터 세트)

Hyun_! 2023. 12. 26. 18:42AIchemist 과제 포스팅을 날려버리는 사태로 분량이 적습니다..😢

07. 문서 군집화 소개와 실습(Opinion Review 데이터 세트)

문서 군집화(Doucment Clustering) : 비슷한 텍스트 구성의 문서를 군집화하는 것.

동일 군집에 속하는 문서를 같은 카테고리 소속으로 분류할 수 있음.

*텍스트 분류 기반 문서 분류와의 차이 : 텍스트 기반 문서 분류는 사전에 결정 카테고리 값을 가진 학습 데이터 세트가 필요함. 문서 군집화는 학습 데이터 세트가 필요없는 비지도학습 기반으로 동작함.

텍스트 기반 문서 군집화를 적용하는 실습 진행!

Opinion Review 데이터 세트를 이용한 문서 군집화 수행하기

내려받은 압축 파일의 topics 디렉터리 안에 리뷰 텍스트 파일들이 있음.

각 파일은 TripAdvisor, Edmunds,com, Amazon.com의 리뷰 문서 (파일 51개, 각 문서는 약 100개 문장)

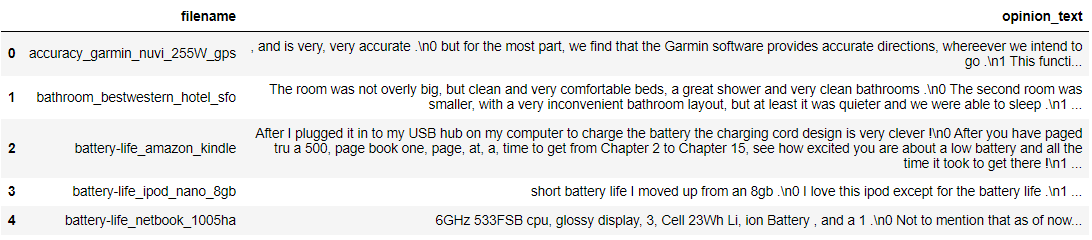

# 데이터 처리를 위해 여러 개의 파일을 한 개의 DataFrame으로 로딩

How To?

(1) 먼저 해당 디렉터리 내의 모든 파일에 대해 각각 for 반복문으로 반복하면서 개별 파일명을 파일명 리스트에 추가하고 개별 파일은 DataFrame으로 읽은 후 다시 문자열로 반환한 뒤 파일 내용 리스트에 추가한다. (*절대 경로 디렉터리를 먼저 지정하고 이 위치에서 데이터를 로딩함.)

(2) 이렇게 만들어진 파일명 리스트와 파일 내용 리스트를 이용해 새롭게 파일명과 파일 매용을 칼럼으로 가지는 DataFrame을 생성한다.

import pandas as pd

import glob, os

import warnings

warnings.filterwarnings('ignore')

pd.set_option('display.max_colwidth', 700)

path = r'C:\Users\SAMSUNG\Downloads\OpinosisDataset1.0\topics'

# path로 지정한 디렉터리 밑에 있는 모든 .data 파일들의 파일명을 리스트로 취합

all_files = glob.glob(os.path.join(path, "*.data"))

filename_list = []

opinion_text = []

# 개별 파일들의 파일명은 filename_list 리스트로 취합,

# 개별 파일들의 파일 내용은 DataFrame 로딩 후 다시 string으로 변환하여 opinion_text 리스트로 취합

for file_ in all_files:

# 개별 파일을 읽어서 DataFrame으로 생성

df = pd.read_table(file_,index_col=None, header=0,encoding='latin1')

# 절대경로로 주어진 file 명을 가공

# 맨 마지막 .data 확장자도 제거

filename_ = file_.split('\\')[-1]

filename = filename_.split('.')[0]

# 파일명 리스트와 파일 내용 리스트에 파일명과 파일 내용을 추가

filename_list.append(filename)

opinion_text.append(df.to_string())

# 파일명 리스트와 파일 내용 리스트를 DataFrame으로 생성

document_df = pd.DataFrame({'filename':filename_list, 'opinion_text':opinion_text})

document_df.head()

# 문서를 TF-IDF 형태로 피처 벡터화

TfidfVectorizer가 어근 변환을 직접 지원x -> tokenizer 인자에 커스텀 어근 변환 함수를 적용해 어근 변환 수행.

LemNormalize() 함수 만들어 사용(책의 부록 소스 코드 참고함)

*ngram(1, 2), min_df와 max_df 범위 설정해 피처 개수 제한.

* TfidfVectorizer의 fit_transform() 인자로 option_text 칼럼 입력해 개별 텍스트 문서 대해 TF-IDF 변환된 피처 벡터화된 행렬 구함.

from nltk.stem import WordNetLemmatizer

import nltk

nltk.download('punkt')

nltk.download('wordnet')

import string

remove_punct_dict = dict((ord(punct), None) for punct in string.punctuation)

lemmar = WordNetLemmatizer()

# 입력으로 들어온 token단어들에 대해서 lemmatization 어근 변환

def LemTokens(tokens):

return [lemmar.lemmatize(token) for token in tokens]

# TfidfVectorizer 객체 생성 시 tokenizer인자로 해당 함수를 설정하여 lemmatization 적용

# 입력으로 문장을 받아서 stop words 제거-> 소문자 변환 -> 단어 토큰화 -> lemmatization 어근 변환

def LemNormalize(text):

return LemTokens(nltk.word_tokenize(text.lower().translate(remove_punct_dict)))from sklearn.feature_extraction.text import TfidfVectorizer

tfidf_vect = TfidfVectorizer(tokenizer=LemNormalize, stop_words='english' , \

ngram_range=(1,2), min_df=0.05, max_df=0.85 )

#opinion_text 컬럼값으로 feature vectorization 수행

feature_vect = tfidf_vect.fit_transform(document_df['opinion_text'])

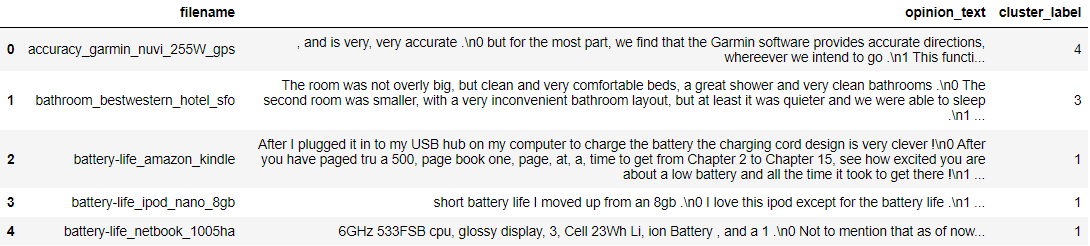

#어떤 문서끼리 군집?

from sklearn.cluster import KMeans

# 5개 집합으로 군집화 수행. 예제를 위해 동일한 클러스터링 결과 도출용 random_state=0

km_cluster = KMeans(n_clusters=5, max_iter=10000, random_state=0)

km_cluster.fit(feature_vect)

cluster_label = km_cluster.labels_

cluster_centers = km_cluster.cluster_centers_

document_df['cluster_label'] = cluster_label

document_df['cluster_label'] = cluster_label

document_df.head()

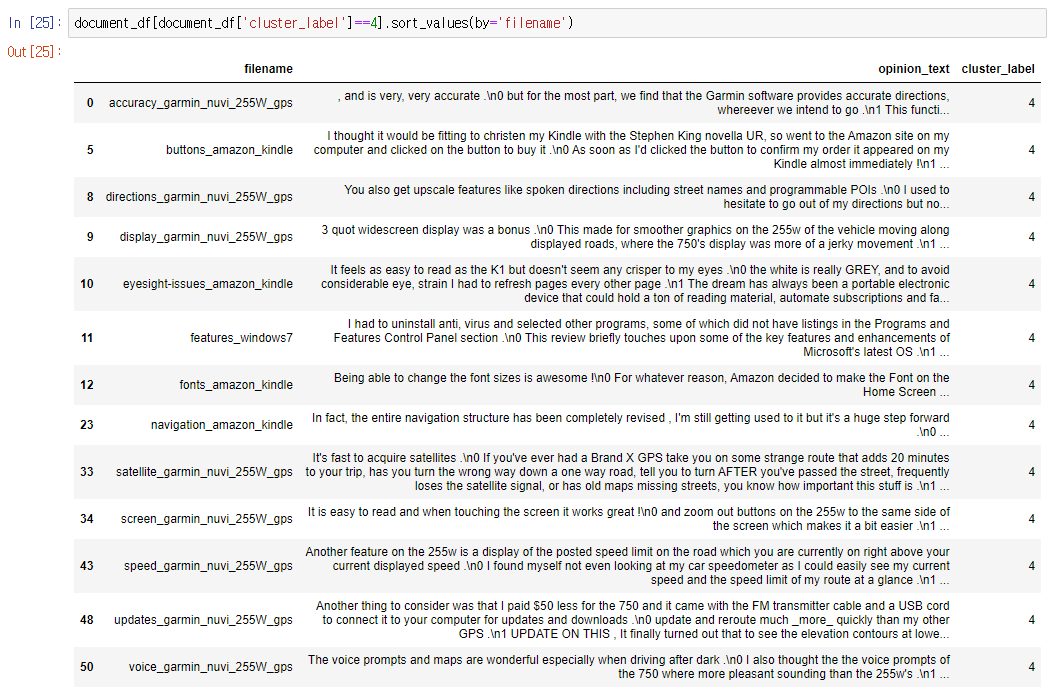

from sklearn.cluster import KMeans

# 3개의 집합으로 군집화

km_cluster = KMeans(n_clusters=3, max_iter=10000, random_state=0)

km_cluster.fit(feature_vect)

cluster_label = km_cluster.labels_

# 소속 클러스터를 cluster_label 컬럼으로 할당하고 cluster_label 값으로 정렬

document_df['cluster_label'] = cluster_label

document_df.sort_values(by='cluster_label')

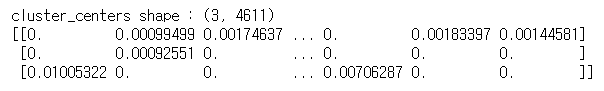

cluster_centers = km_cluster.cluster_centers_

print('cluster_centers shape :',cluster_centers.shape)

print(cluster_centers)

# 군집별 top n 핵심단어, 그 단어의 중심 위치 상대값, 대상 파일명들을 반환함.

def get_cluster_details(cluster_model, cluster_data, feature_names, clusters_num, top_n_features=10):

cluster_details = {}

# cluster_centers array 의 값이 큰 순으로 정렬된 index 값을 반환

# 군집 중심점(centroid)별 할당된 word 피처들의 거리값이 큰 순으로 값을 구하기 위함.

centroid_feature_ordered_ind = cluster_model.cluster_centers_.argsort()[:,::-1]

#개별 군집별로 iteration하면서 핵심단어, 그 단어의 중심 위치 상대값, 대상 파일명 입력

for cluster_num in range(clusters_num):

# 개별 군집별 정보를 담을 데이터 초기화.

cluster_details[cluster_num] = {}

cluster_details[cluster_num]['cluster'] = cluster_num

# cluster_centers_.argsort()[:,::-1] 로 구한 index 를 이용하여 top n 피처 단어를 구함.

top_feature_indexes = centroid_feature_ordered_ind[cluster_num, :top_n_features]

top_features = [ feature_names[ind] for ind in top_feature_indexes ]

# top_feature_indexes를 이용해 해당 피처 단어의 중심 위치 상댓값 구함

top_feature_values = cluster_model.cluster_centers_[cluster_num, top_feature_indexes].tolist()

# cluster_details 딕셔너리 객체에 개별 군집별 핵심 단어와 중심위치 상대값, 그리고 해당 파일명 입력

cluster_details[cluster_num]['top_features'] = top_features

cluster_details[cluster_num]['top_features_value'] = top_feature_values

filenames = cluster_data[cluster_data['cluster_label'] == cluster_num]['filename']

filenames = filenames.values.tolist()

cluster_details[cluster_num]['filenames'] = filenames

return cluster_detailsdef print_cluster_details(cluster_details):

for cluster_num, cluster_detail in cluster_details.items():

print('####### Cluster {0}'.format(cluster_num))

print('Top features:', cluster_detail['top_features'])

print('Reviews 파일명 :',cluster_detail['filenames'][:7])

print('==================================================')feature_names = tfidf_vect.get_feature_names_out()

cluster_details = get_cluster_details(cluster_model=km_cluster, cluster_data=document_df,\

feature_names=feature_names, clusters_num=3, top_n_features=10 )

print_cluster_details(cluster_details)

'Study > Python-Machine-Learning' 카테고리의 다른 글

| 파머완 복습 - 02. 사이킷런으로 시작하는 머신러닝 (0) | 2024.03.23 |

|---|---|

| 파머완 복습 - 01. 파이썬 기반의 머신러닝과 생태계 이해 (0) | 2024.03.23 |

| [AIchemist] 파머완 - CH06. 차원 축소 (1~6) (0) | 2023.11.21 |

| [AIchemist] 파머완 - CH05. 회귀 | 10. 회귀 실습 - 캐글 주택 가격: 고급 회귀 기법 (0) | 2023.11.14 |

| [AIchemist] 파머완 - CH05. 회귀 | 9. 회귀 실습 - 자전거 대여 수요 예측 (0) | 2023.11.07 |